Mbot fue creado en 2010 para cubrir las necesidades especificas de los investigadores en Documentación que se enfrentaban al estudio de la web desde el punto de vista cibermétrico. Las herramientas disponibles hasta el momento como Nutch o Heritrix, aún siendo profesionales, resultaban demasiado complejas de configurar y sus datos, difíciles de tabular. Ello unido a la falta de iniciativas en España, condujo al desarrollo del primer webcrawler multipropósito.

Un webcrawler es un programa informático específicamente diseñado para rastrear la red de forma sectorial o completa, a partir de los enlaces y vínculos de las páginas web que analiza. En el caso de Mbot, se sigue este patrón clásico para el análisis de enlaces y añade otras funciones derivadas, que facilitan las labores académico-científicas y profesionales. Por ejemplo generar un análisis de los formatos de archivos y páginas web encontrados, obtener información de las páginas más enlazadas, el análisis de los metadatos y meta-etiquetas encontrados, el análisis de coenlaces, el establecimiento de rankings de recursos y páginas enlazados, el desarrollo de mapas de la web, entre otras múltiples aplicaciones.

Mbot está especialmente indicado para el desarrollo de análisis temáticos de la web. Esto significa que es posible realizar micro estudios webmétricos que ayuden a comprender la composición de la web en un determinado área de conocimiento, su nivel de interrelación, cuáles son los contenidos más importantes o qué importancia tienen con respecto al resto de elementos analizados.

Durante los procesos de análisis de la web, Mbot organiza y tabula la información automáticamente generando una base de de conocimiento en la que se distribuyen y clasifican los tipos de páginas web según sus formatos y las referencias a los archivos de imagen, audio, vídeo. Por otra parte, almacena las meta-etiquetas estándar y los metadatos Dublin Core, para permitir estudios de recuperación de información y posicionamiento en buscadores. Además, Mbot está diseñado para detectar canales de sindicación, redes semánticas y ontologías, de forma tal que puede realizar tareas de minería de datos especializadas, recabando información primaria a partir de un análisis en profundidad de la web. También es posible configurar Mbot, para la extracción masiva de correos electrónicos, códigos fuente, así como la indexación del texto completo de las páginas web que analizada, función que lo habilita para constituirse no sólo como bot sino como buscador en sí mismo. Si bien Mbot, no tiene por objetivo rivalizar con los grandes rastreadores y robots de búsqueda, sí representa una alternativa eficaz para instituciones y empresas cuyo objetivo es reducir la dependencia de terceros proveedores de servicios de búsqueda y mantener el anonimato de sus consultas, siempre y cuando éstas estén focalizadas a una temática concreta.

Presentación en foros científicos

Mbot tiene una larga trayectoria científica que avala el continuo desarrollo y mejora de las técnicas de crawling y análisis investigadas. La primera prueba pública tuvo lugar en el año 2010, cuando se publicaron las primeras pruebas del Mbot webcrawler. En el año 2011, se realizó la primera prueba de importancia, consistente en el análisis comparado del sitio web de la NASA con respecto a la ESA, que fue presentada en el X Congreso del capítulo español de ISKO. Poco después, en la X Conferencia de Sistemas, cibernética e informática CISCI, celebrada en Florida, se demostró la capacidad de integración de Mbot en programas de gestión de fuentes de información como Cúmulus. En 2012, con motivo del primer seminario Hispano-Brasileño de Documentación, se presenta el análisis webmétrico de los medios de comunicación brasileños, analizando prensa, radio y televisión, obteniendo además el primer mapa de la web de medios de comunicación de Brasil. En 2013, el webcrawler Mbot se presenta en las XIII Jornadas Españolas de Documentación FESABID, aportando un análisis de la web de la universidad española, generando también el primer mapa de la web universitaria española. Desde mayo de 2013 hasta agosto de 2013, se ha desarrollado un importante proceso de modernización y mejora de Mbot, que ha dado lugar a un algoritmo de rastreo más perfeccionado, que ha desembocado en una mejora sustancial de la capacidad y precisión originales del programa, obteniendo una eficacia próxima al 93,45%.

Versiones

4.1 – 2014-01-01 – [En desarrollo]

4.0 – 2013-01-01 – Versión estable. Nuevo sistema de crawling.

3.0 – 2012-01-01 – Mejora del sistema de crawling original.

2.0 – 2011-01-01 – Incorpora representación gráfica en Graphviz.

1.0 – 2010-01-01 – Versión base del programa. Inicio del desarrollo.

Requerimientos del sistema

- Servidor Apache2+ PHP5+ MySQL5+ (Por ejemplo una distribución AppServ o Xampp con librerías básicas posibilitaría su perfecto funcionamiento)

- Multiplataforma Windows, Linux, MacOS

Especificaciones

- Configuración integrada. Todas las opciones de configuración de Mbot, se encuentran disponibles en una misma página, lo que facilita su preparación para múltiples tareas, así como una afinación precisa. En el apartado de configuración del programa se pueden modificar lo datos de instalación, el sistema de correo masivo, el modo de ejecución, el interfaz de visualización de la ejecución del programa, los niveles de análisis, los tipos de contenidos que se desean extraer en el análisis, los filtros que se quieran aplicar y las propiedades del control de ejecución del webcrawler.

- Módulo de mantenimiento. Mbot, dispone de un módulo exclusivamente dedicado al mantenimiento de las tablas de la base de datos, su desfragmentación y reparación, permitiendo monitorizar el estado de las mismas.

- Edición inteligente de semillas. Como todo webcrawler para iniciar su funcionamiento, se requiere una lista de direcciones URL denominada semilla, que toma como base para realizar el análisis de la web. En el caso de Mbot, el módulo que gestiona la semilla comprueba duplicaciones y organiza el orden de lectura y ejecución para garantizar un correcto funcionamiento del programa.

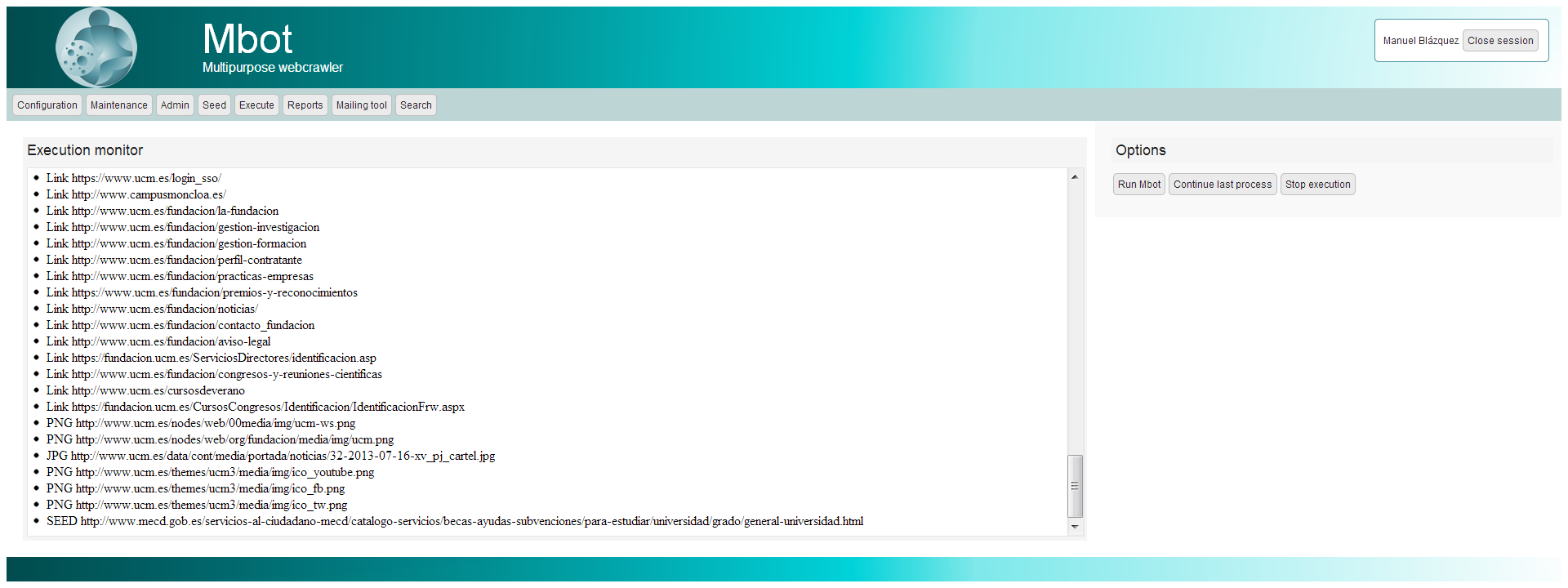

- Módulo de control de ejecución. Mbot ha sido diseñado para funcionar con distintos modos de control de ejecución, por lo que es posible visualizar el avance del análisis, así como los documentos y formatos de contenidos que extrae durante el proceso. Además consta de la opción de paralizar el trabajo de análisis y retomarlo posteriormente cuando sea necesario, lo que permite que cualquier investigador o especialista pueda operar con equipos informáticos no dedicados, poco preparados o no profesionales.

- Módulo de informes. Mbot ofrece información pormenorizada sobre cualquier aspecto cuantificable.

- Análisis de datos general, nivel por nivel.

- Análisis de dominios de primer y segundo nivel.

- Análisis general de formatos de archivo.

- Análisis general de enlaces internos y externos.

- Análisis de enlaces internos y externos dominio por dominio.

- Ranking de páginas web más enlazadas.

- Ranking de sitios web más enlazados.

- Meta-etiquetas por dominio.

- Texto de meta-etiquetas por dominio y página.

- Análisis de frecuencias TF de meta-etiquetas.

- Metadatos por dominio.

- Texto de metadatos por dominio y página.

- Análisis de frecuencias TF de metadatos.

- Ranking de sitios web con más páginas web.

- Ranking de sitios web con más contenidos y documentos.

- Ranking de sitios web con más canales de sindicación.

- Exportación de canales de sindicación.

- Análisis de la macroestructura de la web con los componentes IN, MAIN, OUT, T-IN, T-OUT, TUNNEL.

- Análisis de coenlaces.

- Exportación de archivo gráfico de tipo DOT para generar diagrama gráfico de la web analizada.

- Módulo de búsqueda. Mbot dispone de un sistema de recuperación completamente integrado. Diseñado para realizar consultas sobre el contenido analizado, gracias a su método de indexación patentado y al proceso de depuración textos desarrollado ex-profeso para el programa.

- Módulo de correo masivo. Dada la capacidad de recopilación de correos electrónicos del webcrawler, se ha desarrollado una herramienta completa para realizar envíos masivos de correos electrónicos, permitiendo la edición completa de mensajes en texto plano y HTML, la inclusión de documentos adjuntos, así como la capacidad de envío anónimo.

Capturas de pantalla

Vídeos

Referencias

- BLÁZQUEZ OCHANDO, M. 2010. [eprint]. Primeras pruebas del mbot webcrawler. Disponible en: http://www.mblazquez.es/documents/articulo-pruebas1-mbot.html

- BLÁZQUEZ OCHANDO, M.; SERRANO MASCARAQUE, E. 2011. [Ponencia]. Análisis de la web y usabilidad: prueba de funcionamiento de Mbot webcrawler. En: X Congreso del Capítulo español de ISKO (La Coruña, 30 junio – 1 julio). Disponible en: http://eprints.rclis.org/19104/

- BLÁZQUEZ OCHANDO, M.; SERRANO MASCARAQUE, E. 2011. [Ponencia]. Integración de tecnología webcrawler en sistemas de gestión de fuentes de información: desarrollo de la aplicación Cumulus2. En: Décima conferencia iberoamericana en sistemas, cibernética e informática CISCI (Orlando, 19-22 julio). Vol.3, pp.39-44. Disponible en: http://eprints.rclis.org/19105/

- BLÁZQUEZ OCHANDO, M. 2012. [Ponencia]. Análisis webmétrico de los medios de comunicación brasileños: prensa, radio y televisión. En: I Seminario Hispano Brasileño de Biblioteconomía y Documentación (Madrid, 28-30 noviembre). Disponible en: http://eprints.rclis.org/19033/

- BLÁZQUEZ OCHANDO, M. 2013. [Ponencia]. Desarrollo tecnológico y documental del webcrawler Mbot: prueba de análisis web de la universidad española. En: XIII Jornadas Españolas de Documentación, Fesabid (Toledo, 21-24 mayo).

Usar Mbot

Mbot permite desarrollar procesos de recopilación de información completos o adaptados, partiendo de una colección de enlaces o direcciones URL denominadas «semillas». Por ello es posible efectuar múltiples procesos de análisis de la web, personalizados para cada usuario, atendiendo a los siguientes aspectos.

- El uso que se hará de la información obtenida, ya sea a nivel científico, comercial de minería de datos o publicitario.

- Los informes que seleccione el usuario y su tratamiento.

- El tipo de datos o información que resulta necesario extraer para cumplimentar dichos informes.

- El número de enlaces que figuren en la semilla.

- El número de páginas analizadas.

- El volumen de los datos e informaciones recopiladas.

[…] realmente interesante, creado en el 2010 y que ha sufrido diversas evoluciones desde entonces: El Mbot. El Mbot es un software de rastreo Web en el cual se concentran las principales herramientas para […]

Vaya, tiene una pinta estupenda.

¡¡¡Enhorabuena!!!

[…] ← Anterior […]

Muchas gracias! este ha sido uno de los programas más importantes que he desarrollado. Muy pocas personas conocen realmente las potencialidades de estas aplicaciones y mi intención es presentarlo para su divulgación y conocimiento. Os espero el próximo martes 22 de octubre a las 18:00 horas en la sala de conferencias de la Facultad de Ciencias de la Documentación de la UCM.

Un abrazo y gracias de nuevo.

Prof. Manuel Blázquez

Enhorabuena por tu blog. Me estoy formando e informando sobre la materia y me parece muy buena tu aportaci

[…] Dada la importancia del recurso para la elaboración de próximas investigaciones, que ayuden a determinar la producción científica de tesis doctorales sobre una determinada especialidad o área de conocimiento, se ha desarrollado un método de recuperación de fichas de tesis doctorales, procedentes de la base de datos TESEO. El método consiste en el uso de técnicas de web scraping combinadas con el motor de crawling Mbot. […]

[…] http://www.wausearch.com/ · Proyecto WauSearch http://mblazquez.es/wausearch/ · Proyecto Mbot http://mblazquez.es/mbot/ · WauSearch, un Nuevo buscador. Comunicación Cultural, DosDoce.com […]

[…] Dada la importancia del recurso para la elaboración de próximas investigaciones, que ayuden a determinar la producción científica de tesis doctorales sobre una determinada especialidad o área de conocimiento, se ha desarrollado un método de recuperación de fichas de tesis doctorales, procedentes de la base de datos TESEO. El método consiste en el uso de técnicas de web scraping combinadas con el motor de crawling Mbot. […]

[…] Además se ha conectado el programa de web scraping a un sistema de web crawler propio, basado en Mbot, que permite re-rastrear e indexar los contenidos de los resultados que determine el usuario. De […]

Gracias al taller de Sedic he descubierto tu blog, me apasiona este asunto.

Investigaré e intentaré aplicarlo!.

Un saludo

Ismael